人工智能识别性取向:披着技术外衣的面相学?

近期,一份来自斯坦福大学的研讨宣称,他们的算法能够经过对照片中人物的表情、动作和神态停止剖析,推断出人物的性取向。

但批判家却以为,这只是披上了人工智能外衣的伪科学和面相学。这些早已被西方科学世界摒弃的落后观念,往常在新科技的掩饰下,重新抬头。

研讨的狭隘性

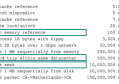

斯坦福的研讨给出了一个看似很高的判别准确度:当人工智能对单张照片剖析时,它猜对图中男性性取向的几率为81%,而女性则为71%。

当每位被剖析人物的照片增加到5张时,算法剖析男性和女性的性取向正确率分别高达91%和83%。

但问题是,研讨人员在测试时,是按两人一组的方式并行测试,每组人物一“直”一“弯”,因而,即便人工智能只是瞎蒙,都能有50%的精确率。

而且,研讨人员宣称算法的剖析只专注于五官研讨,而采用的VGG-Face软件可最小化活动性要素,如打光、姿态和表情等的干扰。

但人工智能面部辨认方向的研讨人员Tom White则表示,VGG-Face捕抓那些活动性元素才能也很强。

再者,这个被作为研讨的根本数据(来自约会网站的图片)自身就是有成见的。

来自美国欧柏林大学的社会学教授Greggor Mattson指出,由于这些照片是从约会网站中抓取的,意味着,这些照片自身就是由用户特地精选,用来吸收特定性取向的人。

也就是说,这些照片都是用户演绎出来,迎合他们以为社会对该性取向人群的定位,换言之——呆板印象。

固然研讨团队也曾将算法拿到研讨以外的素材停止测试,但那些素材自身也是具有成见的。毕竟,并不是一切男同志都会给“我弯我骄傲”这类页面点赞,而有点赞的人,或许也可能会趋于迎合特定呆板印象。

而他们所疏忽的,是这个群体中所包含的,无数的无规律的非典型行为。

这个研讨的主担任人Kosinski也表示,他的研讨也可能是错的,并表示“想要核实结果正确性,我们还得停止更多研讨。”但如何才干肯定研讨不会带有成见呢?对此,Kosinski 的回应是:

想要测试和考证一个结果的正确性,你并不需求了解(研讨)模型的工作原理。

而The Verge则以为,正是这种研讨中的不透明性,才会使得这些研讨充溢了误导性。

人工智能也是人类带着成见制造的新工具

在历史的长河上,人类将本身成见投射于当时最好工具的例子不断都很多。

而将人类表面和人的个性和实质关联的观念,从古希腊时期就曾经存在了,而到了19世纪,更是被工具赋予了“科学”的假象。

当时的面相学研讨者以为,人类额头构成的角度,或是人鼻子的外形,都可作为判别一个人是老实还是有立功倾向的例证。固然这些说法早已被判别为伪科学,但往常却在人工智能时期“重获重生”。

去年,来自上海交大的研讨团队还宣称研发了一个辨识罪犯的神经网络系统,引来了人工智能社区痛斥,三名来自Google的研讨人员更是撰写万字长文批判这些研讨者。

而一家名为Faception的新创企业也宣称能够经过面容剖析来辨认恐惧分子。

但是,人工智能就真的能够客观地剖析和研讨这些数据吗?澳大利亚国立大学的社会学讲师Jenny Davis并不同意:

人工智能并不是真的纯“人工”。

机器学习的方式就和人类学习的方式一样。我们从文化中提取并吸收社会构造的常态,而人工智能也是这样。

因而,它(人工智能)也会再建、扩展并且持续我们人类为它们设下的道路,而这些道路,不断都将反映现存的社会常态。

而无论是依据面容来判别一个人能否老实,或是判别他的性取向,这些算法都是基于社会原有生物实质主义(biological essentialism),这是一种坚信人的性取向等实质是根植于人身体的理论。

Davis还指出,这些是“很有用”的理论,由于它能够从特定人群中提取出某种特质,并经过将该特质定义为“次要、优势”,来成为本来就有成见的人群停止歧视的“合理理由”。

今年年初,来自巴斯大学和普林斯顿大学的计算机科学家就曾用相似IAT(内隐联想检验)的联想类测试来检测算法的潜在倾向性,并发现即便算法也会对种族和性别带有成见。

以至,连Google翻译也难逃成见,算法“发现”并“学习”了社会商定俗成的成见。当在特定言语环境中,一些本来是中性的名词,假如上下文具有特定形容词(中性),它会将中性词转而翻译为“他”或“她”。

说到这里,或许大家曾经能够看出,Kosinski和Wang研讨(斯坦福研讨)的准确性曾经不是最重要的了。

假如有人想置信人工智能能够判别性别取向,(无论精确度如何)他们都会拿来用。

因而,更重要的,是我们要了解人工智能的限制性,并在它形成危害之前中和它。

The Verge评论道。但最费事的,在于大多数时分,我们都没法发觉到本身存在的成见,那我们又怎样可希冀我们做出来的工具是绝对公正的呢?